El uso de asistentes de voz es cada vez mayor: los bajos precios, su utilidad para tareas cotidianas, la necesidad de estar a la última o la irrupción (de nuevo) de la famosa “internet de las cosas” (que permite conectar todos los dispositivos de un hogar) son factores que han facilitado las ventas y su instalación en muchos hogares. Además, muchos usuarios utilizan estos asistentes como sustitutos de la búsqueda en google para las dudas y preguntas cotidianas.

Muchas de estas dudas y preguntas a Siri o Alexa tienen relación con la salud, y dado que muchos usuarios utilizan esas respuestas como consejo de salud, es necesario conocer la calidad de la información que se proporciona así como la comprensión por parte del asistente del problema o duda planteado. No son muchos los estudios sobre estos aspectos, pero existen algunos muy interesantes que merece la pena comentar.

Empezamos por la comprensión. En nature Digital medicine publicaron en 2019 un artículo acerca de los nombres de los medicamentos y si los asistentes de voz eran capaces de entenderlos. Se preguntó a los asistentes por la marca y la denominación genérica de los 50 medicamentos más vendidos en Estados Unidos y los resultados fueron muy sorprendentes. Google alcanzó el mejor resultado, ya que entendió el 91,8% de las marcas y el 84,3% de la denominación del genérico. Siri obtuvo un resultado intermedio, con 58,5% y 51,2% respectivamente. Finalmente, Alexa obtuvo el peor resultado con 54,6% y 45,5%. Es decir, en el caso de Alexa solo entendía la mitad de los medicamentos.

El segundo estudio, publicado en 2019 en BMJ Health Care Informatics, se centró en evaluar la calidad de las respuestas de los tres dispositivos más habituales (Siri, Alexa y Google) sobre el uso y la seguridad de las vacunas. La mayor puntuación fue para Siri y Google, frente a Alexa. El motivo es que, dado que Siri y Google son asistentes que se usaron con un teléfono, cuando el asistente desconocía la respuesta, dirigía al usuario a un enlace externo de confianza. En el caso de Alexa, cuando no conocía la respuesta, sencillamente respondía “Sorry, I don’t know that” por lo que su puntuación fue inferior. Otro motivo de esta baja puntuación fueron las fuentes utilizadas, dado que Alexa solía recurrir a Wikipedia, mientras que Siri y Google ofrecían información del CDC, Mayo Clinic o la OMS.

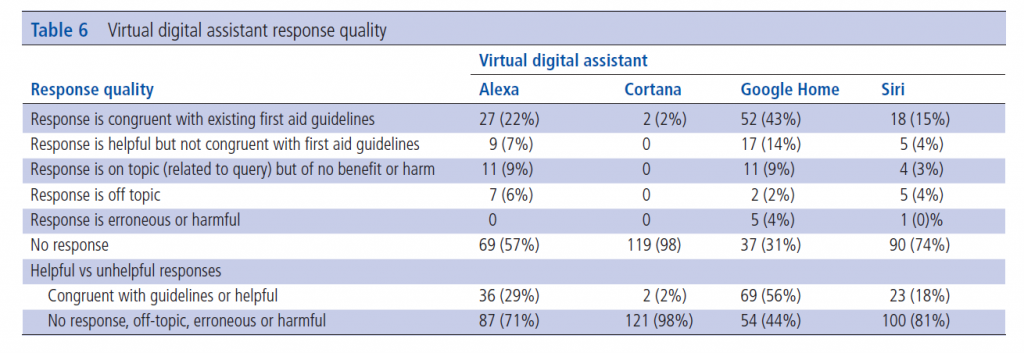

Finalmente, en diciembre de 2019 se publicó en BMJ Innovation un artículo que compara la calidad de las respuestas de cuatro asistentes de voz (los tres habituales y Cortana) ante preguntas básicas de primeros auxilios. En este estudio, Alexa y Google Home superaron el 90% en el reconocimiento de la pregunta, frente a un 23% de Siri y un 19% de Cortana. Sin embargo, al comparar la calidad de las respuestas de Alexa y Google al compararlas con lo que establecen las guías, la congruencia fue baja ya que solo un 56% de las respuestas de Google y un 19% de las de Alexa estaban basadas en la evidencia.

¿Cuál es el mejor asistente de voz? Pues todos, o ninguno. No olvidemos que estos asistentes y sus algoritmos mejoran constantemente y, de hecho, los estudios comentados ya están obsoletos porque han pasado casi dos años. Lo más llamativo es como el funcionamiento de cada uno (decidido por humanos) es clave para diferenciar la calidad de las respuestas, y así no es lo mismo basar las respuestas en wikipedia, en el CDC o en el ministerio de sanidad.

Pero nos gustaría sacar otra conclusión: en el último artículo pasaron 15 meses desde la fecha de envío a la fecha de publicación. Quince meses es un plazo demasiado largo para investigaciones relacionadas con la tecnología, lo que provoca que los resultados estén casi obsoletos desde el primer momento. A efectos de comparación, en el primer artículo dicho plazo fue de 4 meses y en el segundo de 6 meses.

Referencias:

– Palanica, A., Thommandram, A., Lee, A. et al. Do you understand the words that are comin outta my mouth? Voice assistant comprehension of medication names. npj Digit. Med. 2, 55 (2019).

– Alagha EC, Helbing RREvaluating the quality of voice assistants’ responses to consumer health questions about vaccines: an exploratory comparison of Alexa, Google Assistant and SiriBMJ Health & Care Informatics 2019;26:e100075.

– Picard C, Smith KE, Picard K, et alCan Alexa, Cortana, Google Assistant and Siri save your life? A mixed-methods analysis of virtual digital assistants and their responses to first aid and basic life support queriesBMJ Innovations Published Online First: 07 January 2020.